2025年3月24日,DeepSeek以标志性的低调风格发布了V3模型的小版本更新——DeepSeek-V3-0324。尽管并非传闻中的V4或R2版本,但此次升级凭借6850亿参数规模、编程能力的突破性提升以及更开放的开源协议,迅速成为全球开发者社区的热议焦点。以下从技术升级、性能实测、生态影响三大维度全面拆解这一版本的核心价值。

一、技术升级:参数规模与架构优化

1. 参数扩容与训练效率

-

• 新版模型参数量从初代V3的6710亿提升至6850亿,激活参数保持370亿规模,通过动态稀疏架构优化推理效率。 -

• 后训练阶段采用新型32K GPU集群,结合强化学习驱动的自我验证机制,显著降低训练成本(初代V3仅耗资557.6万美元即实现媲美Claude 3.5的性能)。

2. 编程能力跃迁

此次升级的核心亮点在于代码生成与理解能力的质变:

-

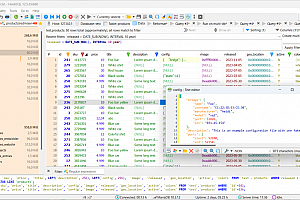

• 前端开发:在生成包含HTML、CSS、JavaScript的复杂动画网页时,代码质量已接近Claude 3.7 Sonnet水平。例如,在“动态天气卡片”测试中,新版V3生成的代码逻辑完整性与可执行性远超R1版本。 -

• 语言支持:对Java、TypeScript等语言的错误检测和补全能力提升显著,开发者实测反馈其“接近专家级程序员水准”。 -

• 数学推理:通过引入多token预测(MTP)目标,模型在AMC等数学竞赛测试中的准确率进一步优化。

3. 对话交互的人性化演进

-

• 新版模型在多轮对话中展现出更强的上下文连贯性,语气更自然,部分用户评价其“用词和节奏更像人类对话”。

二、性能实测:开源模型的「越级挑战」

1. 基准测试表现

-

• 虽暂无官方榜单数据,但用户实测显示,新版V3在Chatbot Arena等竞技场中的综合表现已接近闭源模型Claude 3.7 Sonnet,尤其在技术性任务(如代码生成、数学解题)中差距进一步缩小。 -

• 生成速度维持60 TPS(每秒60 token),延续初代V3的极速响应优势。

2. 开发者实测案例

-

• 天气卡片生成测试: 对比R1版本,新版代码的模块化设计、动画平滑度及注释完整性均更优。

-

• 成本效益:企业用户反馈,基于V3-0324搭建多语言客服系统的成本仅为GPT-4企业版的1/17。

三、生态影响:MIT许可下的开源革命

1. 开源协议升级

-

• 新版V3采用MIT许可证,允许开发者自由商用、修改和二次分发,彻底打破闭源模型的商业壁垒。 -

• 对比初代V3的许可限制,MIT协议显著降低企业合规风险,加速AI技术普惠化。

2. 社区生态爆发

-

• Hugging Face平台:发布数小时内,衍生出23个垂直领域微调模型(如医疗问答、法律文书生成),形成“模型雨林”生态。 -

• 工具链支持:SGLang、LMDeploy等框架已适配V3-0324,开发者可一键部署模型推理服务。

四、未来展望:R2的「前哨战」

尽管DeepSeek未透露R2发布时间,但V3-0324的升级已释放关键信号:

-

• 技术储备验证:动态稀疏架构与MIT许可或成为R2的核心技术范式。 -

• 用户需求响应:针对开发者呼声最高的编程与对话体验优化,此次升级为R2的“全模态能力”埋下伏笔。

🚀 行动指南

开发者可通过以下途径快速体验DeepSeek-V3-0324:

-

1. 官方渠道:访问DeepSeek官网或App,关闭“深度思考”功能体验极速响应。

-

3. 商业接入:利用MIT许可优势,将模型集成至企业工作流,成本低至每百万输出token 2元(优惠期内)。

此次更新不仅是一次技术迭代,更标志着开源AI从“追随者”向“定义者”的角色转变。当开发者们在OpenRouter上输入第一个Prompt时,或许已悄然推开AGI时代的另一扇门。

![[开源]一站式、多租户机器学习平台,集成多种开源机器学习框架](https://www.baicxx.com/wp-content/themes/ceomax/timthumb.php?src=https://www.baicxx.com/wp-content/uploads/2025/04/640-16.jpeg&h=200&w=300&zc=1&a=t&q=100&s=1)